— 给大家拜年啦!蛇年到,好运绕!—

— 祝您:蛇年行大运!步步高升!岁岁安康!—

人们普遍认为,不断扩大数据规模和模型规模能够显著提升模型的智能水平。然而,无论是密集型模型还是混合专家(MoE)模型,研究界和产业界在有效扩展超大规模模型方面经验仍相对有限。直到最近DeepSeek V3的发布,有关这一扩展过程的许多关键细节才得以披露。

![图片[1]-通义千问团队发布Qwen2.5-Max,比DeepSeek V3性能更优!-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2025/02/1738364523622_0.png)

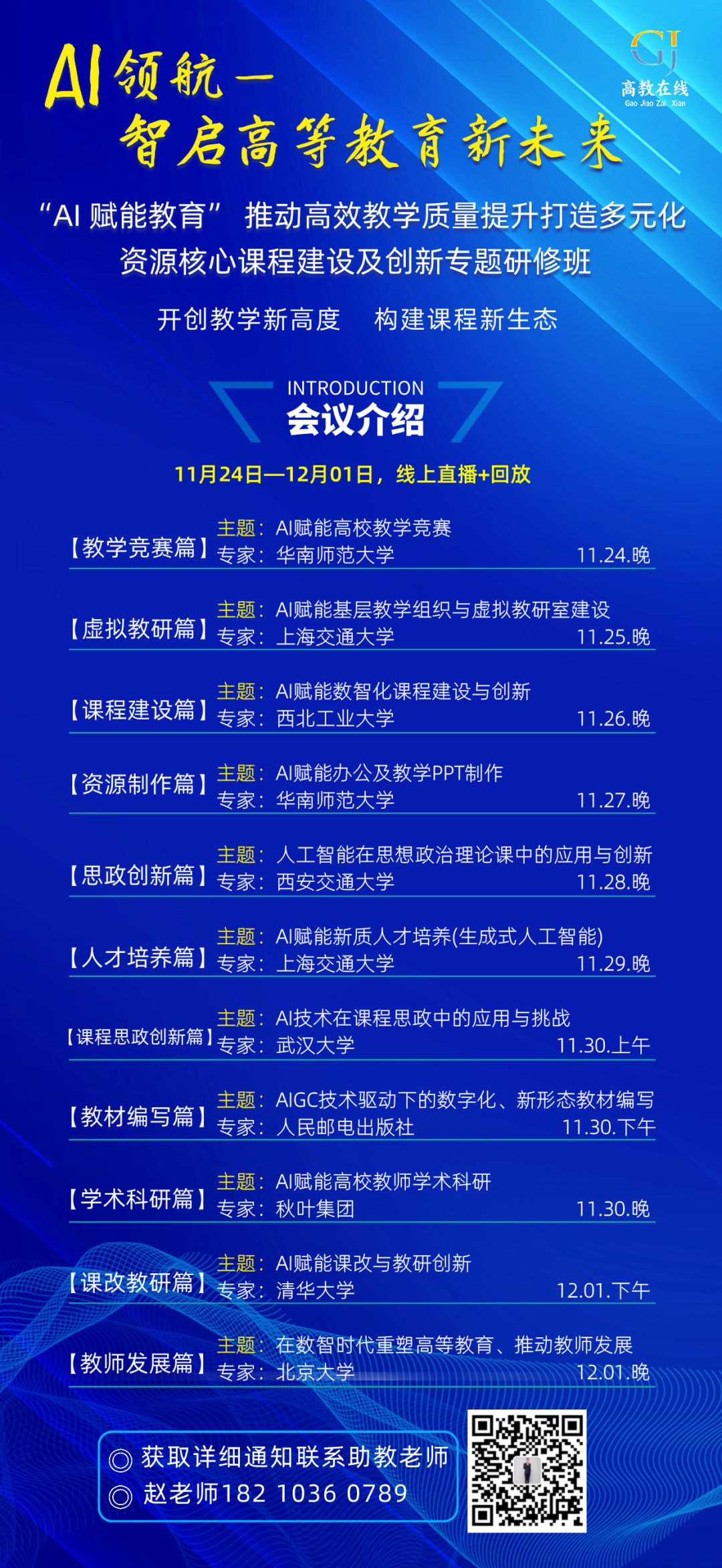

与此同时,通义千问团队一直在开发Qwen2.5-Max,这是一款大规模混合专家模型,已在超过20万亿词元上进行预训练,并通过精心策划的监督微调(SFT)和基于人类反馈的强化学习(RLHF)方法进一步进行后训练。今天,通义千问团队正式发布Qwen2.5-Max,并宣布通过阿里云提供其API。

性能表现:

Qwen2.5-Max与其他领先模型(包括专有模型和开源权重模型)一起,在一系列社区高度关注的基准测试中进行评估。这些基准测试包括通过大学水平问题测试知识的MMLU-Pro、评估编码能力的LiveCodeBench、全面测试通用能力的LiveBench,以及模拟人类偏好的Arena-Hard。研究结果涵盖了基础模型和指令模型的性能得分。

首先,直接对比可用于聊天和编码等下游应用的指令模型的性能。通义千问团队展示了Qwen2.5-Max与当前最先进的领先模型(包括DeepSeek V3、GPT-4o和Claude-3.5-Sonnet)的性能结果。

![图片[2]-通义千问团队发布Qwen2.5-Max,比DeepSeek V3性能更优!-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2025/02/1738364523622_1.jpg)

在Arena-Hard、LiveBench、LiveCodeBench和GPQA-Diamond等基准测试中,Qwen2.5-Max的表现优于DeepSeek V3,同时在包括MMLU-Pro在内的其他评估中也展现出具有竞争力的结果。

在对比基础模型时,由于无法访问GPT-4o和Claude-3.5-Sonnet等专有模型的基座模型。因此,通义千问团队将Qwen2.5-Max与领先的开源权重混合专家模型DeepSeek V3、最大的开源权重密集型模型Llama-3.1-405B,以及同样位列顶尖开源权重密集型模型的通义千问2.5-72B进行评估。Qwen2.5-Max模型在大多数基准测试中展现出显著优势,并且通义千问团队乐观地认为,后训练技术的进步将把Qwen2.5-Max的下一版本提升到新高度。

![图片[3]-通义千问团队发布Qwen2.5-Max,比DeepSeek V3性能更优!-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2025/02/1738364523622_2.jpg)

该团队表示,持续提升数据规模和模型参数规模能够有效提升模型的智能水平。接下来,他们将持续探索,除了在pretraining的scaling继续探索外,将大力投入强化学习的scaling,希望能实现超越人类的智能,推动AI探索未知之境。