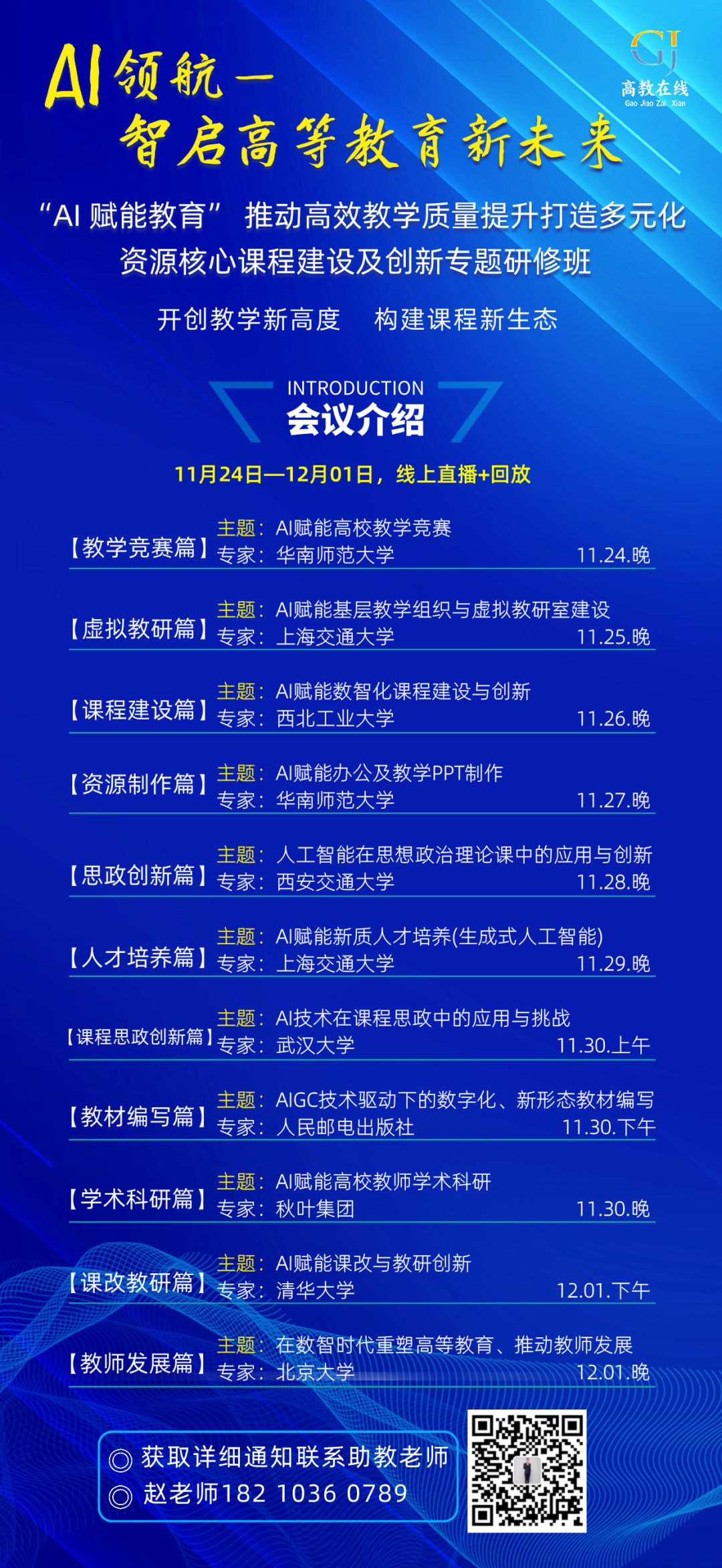

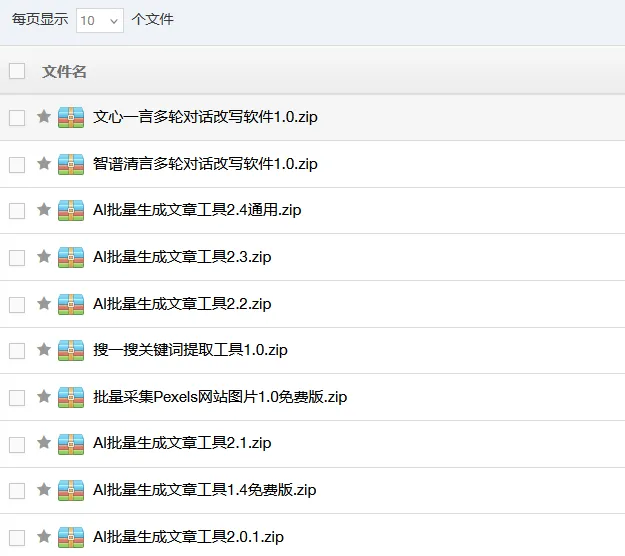

可领取本部资源

有七月在线类ChatGPT微调实战这个课

七月在线类ChatGPT微调实战

![图片[1]-七月在线类ChatGPT微调实战-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2025/01/1737586993209_0.jpg)

七月在线类ChatGPT微调实战

随着人工智能技术的飞速发展,自然语言处理领域迎来了前所未有的变革。七月在线类ChatGPT微调实战,成为众多技术爱好者和企业关注的焦点。在这个充满挑战与机遇的时代,掌握类ChatGPT模型的微调技术,不仅意味着能够更好地利用人工智能为业务赋能,更是在数字化转型浪潮中抢占先机的关键一步。

七月在线类ChatGPT微调实战,首先需要对ChatGPT模型的架构和原理有深入的理解。ChatGPT作为一种基于Transformer架构的生成式语言模型,通过海量文本数据的训练,能够生成流畅且具有一定逻辑性的文本内容。然而,其通用性也意味着在特定领域或特定任务上,模型的表现可能并不尽如人意。这就需要通过微调来优化模型,使其更好地适应特定的需求。微调的过程,本质上是对模型进行再训练的过程,通过在特定数据集上继续训练,调整模型的参数,使其能够更好地理解并生成符合特定领域或任务要求的文本。

在七月在线类ChatGPT微调实战中,数据的选择至关重要。数据的质量和多样性直接影响到微调的效果。对于特定领域,如医疗、金融或法律等,需要收集大量高质量的领域相关文本数据。这些数据不仅要有足够的数量,还要涵盖该领域的各种典型场景和问题。例如,在医疗领域,数据可以包括病历记录、医学文献、诊断报告等;在金融领域,则可以包括金融新闻、市场分析报告、投资建议等。通过对这些领域特定数据的微调,模型能够更好地理解该领域的专业术语、逻辑结构和语义关系,从而生成更准确、更有价值的文本内容。

除了数据的选择,微调过程中的参数设置也是一个关键环节。七月在线类ChatGPT微调实战需要根据具体的任务和数据特点,合理调整学习率、训练轮数、批大小等参数。学习率决定了模型在训练过程中的学习速度,过高的学习率可能导致模型无法收敛,而过低的学习率则会使训练过程过于缓慢。训练轮数则需要根据数据的复杂性和模型的性能来确定,过多的训练轮数可能导致过拟合,而过少的训练轮数则无法充分优化模型。批大小则影响模型的训练效率和内存占用,较大的批大小可以提高训练效率,但也可能导致内存不足的问题。通过不断实验和调整这些参数,可以找到最适合特定任务的微调方案,从而实现模型性能的最大化。

在七月在线类ChatGPT微调实战中,评估模型的性能也是一个不可忽视的环节。微调后的模型需要通过一系列的评估指标来衡量其效果。常见的评估指标包括准确率、召回率、F1值等,这些指标可以帮助我们了解模型在特定任务上的表现。此外,还可以通过人工评估的方式,对模型生成的文本内容进行主观评价,检查其是否符合领域要求和逻辑连贯性。通过综合评估模型的性能,我们可以发现模型的优点和不足之处,从而进一步优化微调策略,提高模型的实用性。

七月在线类ChatGPT微调实战不仅是一项技术挑战,更是一个充满创新和探索的过程。通过微调,我们可以让ChatGPT模型更好地服务于特定领域和任务,为各行各业带来更高效、更智能的解决方案。无论是企业希望提升自身的数字化能力,还是个人开发者希望在人工智能领域有所建树,掌握类ChatGPT模型的微调技术都是一项重要的技能。在未来,随着人工智能技术的不断发展,类ChatGPT模型的微调技术也将不断演进,为人类社会的发展贡献更多的智慧和力量。