![图片[1]-【LLM】大语言模型知识冲突的研究综述-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723752198783_0.png)

一、结论写在前面

论文对知识冲突进行了广泛的研究,阐明了它们的分类、原因、LLM如何应对这些冲突以及可能的解决方案。研究发现,知识冲突是一个多方面的问题,模型的行为与冲突知识的特定类型密切相关。此外,三种冲突类型之间似乎存在更复杂的相互作用。此外,论文观察到现有的解决方案主要解决了人工构建的情景,忽视了冲突的微妙之处,依赖假设的先验,从而牺牲了细粒度和广度。鉴于检索增强语言模型(RALM)的不断增长的使用,论文预计LLM面临的知识冲突只会变得更加复杂,这凸显了在这一领域进行更全面研究的必要性。

二、论文的简单介绍 2.1 论文背景

大型语言模型(LLM)以囊括大量世界知识而著称,被称为参数知识。这些模型擅长处理知识密集型任务,包括问答、事实核查、知识生成等。同时,LLM在部署后会持续接触外部情境知识,包括用户提示、互动对话或从网络检索的文档和工具。

![图片[2]-【LLM】大语言模型知识冲突的研究综述-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723752198783_1.png)

将情境知识整合进LLM使其能跟上时事,并产生更准确的响应,但也可能因丰富的知识源而产生冲突,即所谓的知识冲突。

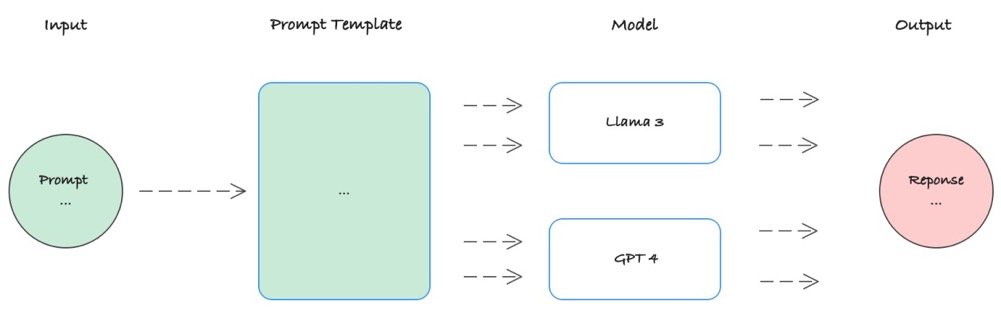

本文将知识冲突分为三类,如图1所示。例如,当使用LLM回答用户问题时,用户可能会提供补充提示,而LLM也会利用搜索引擎从网络收集相关文档来增强知识。这些用户提示、对话历史和检索文档就构成了情境知识(context)。情境知识可能会与LLM参数中内含的参数知识(memory)产生冲突,论文称之为情境-记忆冲突(CM)。在现实场景中,外部文档可能存在噪音或虚假信息,使处理和响应准确度降低,这就是所谓的情境间冲突(IC)。为降低响应的不确定性,用户可能会以不同形式提出同一个问题。因此,LLM的参数知识可能会对不同表述的问题产生不一致的响应,这种由于预训练数据集内在的矛盾而引起的LLM参数内部知识冲突,被称为记忆内冲突(IM)。

就论文所知,目前还没有系统性的综述专门研究知识冲突。现有的评论(Zhang等,2023年d;Wang等,2023年a;Feng等,2023年)只是在更广泛的背景下涉及了知识冲突这一子主题。虽然Feng等人(2023年)对知识冲突进行了较为系统的研究,将其分为外部和内部冲突,但他们的综述仅提供了相关工作的简要概述,主要关注特定场景。为填补这一空白,论文旨在提供一份全面的评论,包括知识冲突的分类、原因和行为分析以及解决方案。

![图片[3]-【LLM】大语言模型知识冲突的研究综述-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723752198783_2.png)

论文综述的方法论如图2所示,论文将知识冲突的生命周期概念化为导致模型中各种行为的原因,以及由知识的本质所引起的效应。知识冲突是原因和模型行为之间的关键中介。例如,它们是模型产生事实错误信息(即幻觉)的重要原因之一。论文的研究强调理解这些冲突根源的重要性,有点类似于弗洛伊德的精神分析学。尽管现有分析往往人为构建了这种冲突,但论文认为这些分析没有充分解决问题的相互关联性。除了综述和分析原因和行为外,论文还深入系统地探讨了解决方案,旨在减少知识冲突带来的不利后果,即鼓励模型展现出符合特定目标的预期行为(需注意这些目标可能因情况而异)。根据与潜在冲突的时间关系,策略分为两类:预先和事后策略。它们的关键区别在于是否在潜在冲突发生之前就作出调整。

![图片[4]-【LLM】大语言模型知识冲突的研究综述-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723752198783_3.png)

![图片[5]-【LLM】大语言模型知识冲突的研究综述-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723752198783_4.png)

2.2 知识冲突详情 2.2.1 情境-记忆冲突

情境-记忆冲突是三种冲突类型中研究最广泛的。大型语言模型具有固定的参数知识,这是大量预训练过程的结果。这种静态的参数知识与外部信息的动态特性形成鲜明对比,后者发展变化极为迅速。

2.2.1.1 起因

情境-记忆冲突的核心源于情境知识与参数知识之间的差异。论文认为主要有两个原因:时间误差和虚假信息污染。

时间失衡和错误信息污染是导致上下文记忆冲突的两种不同情况。对于前者,最新的上下文信息被认为是准确的。相反,对于后者,上下文信息包含错误信息,因此被认为是不正确的。

2.2.1.2 解决方案

忠于情境(Faithful to Context):

•微调(Fine-tuning)。Li等人认为,LLM应该优先考虑与任务相关的情境信息,而在情境无关时则依赖内部知识,并将这两个属性命名为可控性和鲁棒性。他们提出了知识感知微调(KAFT),通过将反事实和无关情境纳入标准训练数据集,来增强这两个属性。Gekhman等人提出TrueTeacher,侧重于利用LLM标注模型生成的摘要,从而提高摘要的事实一致性。这种方法有助于保持对原始文档情境的忠实度,确保生成的摘要保持准确,不被无关或不正确的细节误导。DIAL专注于通过直接知识增强和RLFC来提高对话系统的事实一致性,精准地将响应与提供的事实知识保持一致。

•提示(Prompting)。Zhou等人探索通过专门的提示策略来增强LLM对情境的遵从度,尤其是基于观点的提示和反事实示范。这些技术被证明可以显著提高LLM在情境敏感任务中的性能,确保它们保持对相关情境的忠实,而无需额外训练。

•解码(Decoding)。Shi等人提出情境感知解码(CAD),通过放大有无情境输出概率之差,来减少幻觉,这与对比解码(contrastive decoding)的概念类似。CAD通过有效优先考虑相关情境而非模型的先验知识,从而增强了LLM对情境的忠实度,尤其在存在矛盾信息的任务中。

•知识插件(Knowledge Plug-in)。Lee等人提出持续更新问答(CuQA),以改善LM整合新知识的能力。他们的方法使用即插即用模块来存储更新的知识,确保原始模型不受影响。与传统的持续预训练或微调方法不同,CuQA可以解决知识冲突问题。

•预训练(Pre-training)。ICLM是一种新的预训练方法,旨在扩展LLM处理多文档长期变化情境的能力。这种方法有望通过使模型能够从更广泛的情境中综合信息,从而提高其对相关知识的理解和应用,进而解决知识冲突问题。

•预测事实有效性(Predict Fact Validit)。Zhang和Choi(2023)通过引入事实期限预测来解决知识冲突,旨在识别并丢弃LLM中过时的事实。这种方法通过确保对最新情境信息的遵从,改善了模型在ODQA等任务上的性能。

识别虚假信息(忠于记忆,Discriminating Misinformation (Faithful to Memory)):

分离知识源:(Disentangling Sources)

DisentQA(Neeman等,2022)训练了一个模型,对给定的问题预测两种类型的答案:基于情境知识的答案和基于参数知识的答案。Wang等人(2023g)提出了一种改进LLM处理知识冲突的方法。他们的方法包括三个步骤,旨在帮助LLM检测冲突、准确识别矛盾段落,并基于矛盾数据生成不同明了的响应,以实现更精确和细微的模型输出。

改善事实性(Improving Factuality):

Zhang等人(2023e)提出了COMBO框架,将兼容的生成文本和检索文本配对以解决矛盾。它使用在银标签上训练的判别器来评估文本兼容性,通过利用LLM生成(参数)和外部检索知识来改善ODQA性能。Jin等人(2024a)提出了一种基于对比解码的算法CD2,它最大化了知识冲突下各个logits之间的差异,并校准了模型对真实答案的置信度。

2.2.2 情境间冲突

当LLM整合外部信息源时,就会出现情境间冲突,这是一个由检索增强生成(RAG)技术的兴起而加剧的挑战。RAG通过将检索到的文档内容整合到上下文中,来丰富LLM的响应。然而,这种整合可能会导致所提供的上下文内部出现不一致的情况,因为外部文档可能包含彼此冲突的信息。

2.2.2.1 起因

虚假信息。在当代数字时代,虚假信息一直是一个重大隐患。RAG技术的出现为LLM引入了从外部文档中获取知识的新方式,有望通过多样化的知识源丰富内容。然而,这种方法也存在包含虚假信息(如假新闻)的风险。而且,过去也曾有人利用人工智能技术制造或传播虚假信息。LLM强大的生成能力加剧了这一问题,导致这些系统生成的虚假信息增加,不仅助长了虚假信息的传播,也增加了检测由LLM生成的虚假信息的难度。

过时信息。除了虚假信息的挑战,论文还需认识到事实会随时间而变化。从网络上检索到的文档可能同时包含了最新和过时的信息,从而导致这些文档之间存在冲突。

2.2.2.2 解决方案

消除冲突:

提高鲁棒性:

2.2.3 内存内冲突(Intra-Memory Conflict)

随着大型语言模型(LLM)的发展,LLM被广泛应用于知识密集型问答系统。有效部署LLM的一个关键方面是确保它们对表达相似意义或意图的不同表述能给出一致的输出。尽管如此,LLM存在一个显著的挑战,即记忆内冲突——当面对语义等价但语法不同的输入时,LLM会表现出不可预测的行为并产生不同的响应。记忆内冲突本质上降低了LLM的可靠性和实用性,给其输出带来了不确定性。

2.2.3.1 起因

大型语言模型内部记忆的冲突可归因于三个主要因素:训练语料库偏差(Wang et al., 2023d; Xu et al., 2022)、解码策略(Lee et al., 2022b; Huang et al., 2023)和知识编辑(Yao et al., 2023; Li et al., 2023f)。这些因素分别与训练阶段、推理阶段和后续知识精炼有关。

训练语料库偏差。最新研究表明,大型语言模型获取知识的主要阶段主要发生在预训练阶段(Zhou et al., 2023a; Kaddour et al., 2023; Naveed et al., 2023; Akyürek et al., 2022; Singhal et al., 2022)。预训练语料库主要是从互联网上抓取的,其数据质量存在很大差异,可能包含不准确或误导性信息(Bender et al., 2021; Weidinger et al., 2021)。当大型语言模型在包含错误知识的数据上训练时,它们可能会记住并无意中放大这些不准确信息(Lin et al., 2022; Elazar et al., 2022; Lam et al., 2022; Grosse et al., 2023),导致矛盾知识并存于大型语言模型的参数中。

此外,先前的研究表明,大型语言模型倾向于编码训练数据中普遍存在的肤浅联系,而不是真正理解其中蕴含的底层知识(Li et al., 2022b; Kang and Choi, 2023; Zhao et al., 2023a; Kandpal et al., 2023)。这可能导致大型语言模型表现出生成基于训练数据中虚假相关性的预定响应的倾向。由于依赖于虚假相关性,当面临具有不同语法结构但传达等效语义含义的提示时,大型语言模型可能会给出不同的答案。

解码策略。大型语言模型的直接输出是潜在下一个标记的概率分布。从该分布中确定生成内容的关键步骤是采样。贪婪采样、top-p采样、top-k采样等各种采样技术已被提出(Jawahar et al., 2020; Massarelli et al., 2020),大致可分为确定性和随机采样方法。随机采样是大型语言模型所采用的主导解码策略(Fan et al., 2018; Holtzman et al., 2020)。然而,随机采样方法的随机性为生成的内容引入了不确定性。此外,由于大型语言模型固有的从左到右生成模式,采样标记的选择可能会对后续生成产生重大影响。使用随机采样可能导致大型语言模型在提供相同上下文时产生完全不同的内容,从而导致内存内冲突(Lee et al., 2022b; Huang et al., 2023; Dziri et al., 2021)。

知识编辑。随着模型参数的指数级增长,微调大型语言模型变得越来越具有挑战性和资源密集型。为应对这一挑战,研究人员探索了知识编辑技术,作为有效修改大型语言模型中编码的少量知识的一种手段(Meng et al., 2022; Ilharco et al., 2022; Zhong et al., 2023)。确保修改的一致性是一个重大挑战。由于编辑方法的潜在局限性,修改后的知识无法有效地概括。这可能导致大型语言模型在处理不同情况下的同一知识时产生不一致的响应(Li et al., 2023f; Yao et al., 2023)。内存内冲突主要被视为知识编辑背景下的一种副作用。

2.2.3.2 解决方案

提高一致性:

提高事实性:

论文标题:Knowledge Conflicts for LLMs: A Survey

论文链接: