修订记录

![图片[1]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_0.png)

读者对象

本文档适用于以下人群:

想学习AI绘画,并作为自己生产力的人。

想了解 Stable Diffusion 普通学生或工作者。

今天正式入坑Stable Diffusion,可点击文末的原文,进行原文阅读,体验更佳。另外视频教程,正在加紧制作中。

背景信息▍现阶段市面上有哪些AI绘画产品?我们应该如何选择?

罗列一些主流的AI绘画产品,并简单介绍各个AI绘画产品的定位和特性,以便大家有个全局概念,进行抉择。

首先,根据国内和国外进行一个归类分组:

国外:Stable Diffusion(简称SD)、Midjourney、DALL-E 3、Firefly Image 2。

国内:百度文心一格、阿里通义万相、美图WHEE、360鸿图、海艺AI......

根据AI绘画的质量和口碑上进行一个归类分组:

第一梯队:Stable Diffusion(简称SD)、Midjourney。

第二梯队:DALL-E 3、Firefly Image 2。

第三梯队:百度文心一格、阿里通义万相、美图WHEE、360鸿图、海艺AI......

若你要入坑AI绘画且需求较高,并不是仅体验一下,那么推荐Stable Diffusion或Midjourney;若你为了新鲜感想去体验下那么推荐DALL-E 3、Firefly Image 2、百度文心一格、阿里通义万相。

▍Stable Diffusion 是什么?

Stable Diffusion(简称SD)是一种生成式人工智能,于2022年发布,主要用于根据文本描述生成详细图像,也可用于其他任务,如图像的修补、扩展和通过文本提示指导图像到图像的转换。除图像外,您还可以使用该模型创建视频和动画。

这是AI绘画第一次能在可以在消费级显卡上运行,任何人都可以下载模型并生成自己的图像。另外,SD高质量的成图以及强大的自由度(自定义、个性化)受到诸多网友的追捧。Stable

Diffusion XL 1.0 (SDXL 1.0) 是Stable Diffusion的一个更为高级和优化的版本,它在模型规模、图像质量、语言理解和模型架构等方面都有显著的改进。

▍Stable Diffusion 能做什么?

首先,大家在入坑SD前,务必要清楚现阶段的SD到底能做什么?能否满足自己的需求?

Stable Diffusion 功能包括文本转图像、图像转图像、图形插图、图像编辑和视频创作。

▍Stable Diffusion如何使用?

使用Stable Diffusion的方式一般有三种:一是部署在个人电脑上,二是部署在云端上,三是在某些平台在线使用。

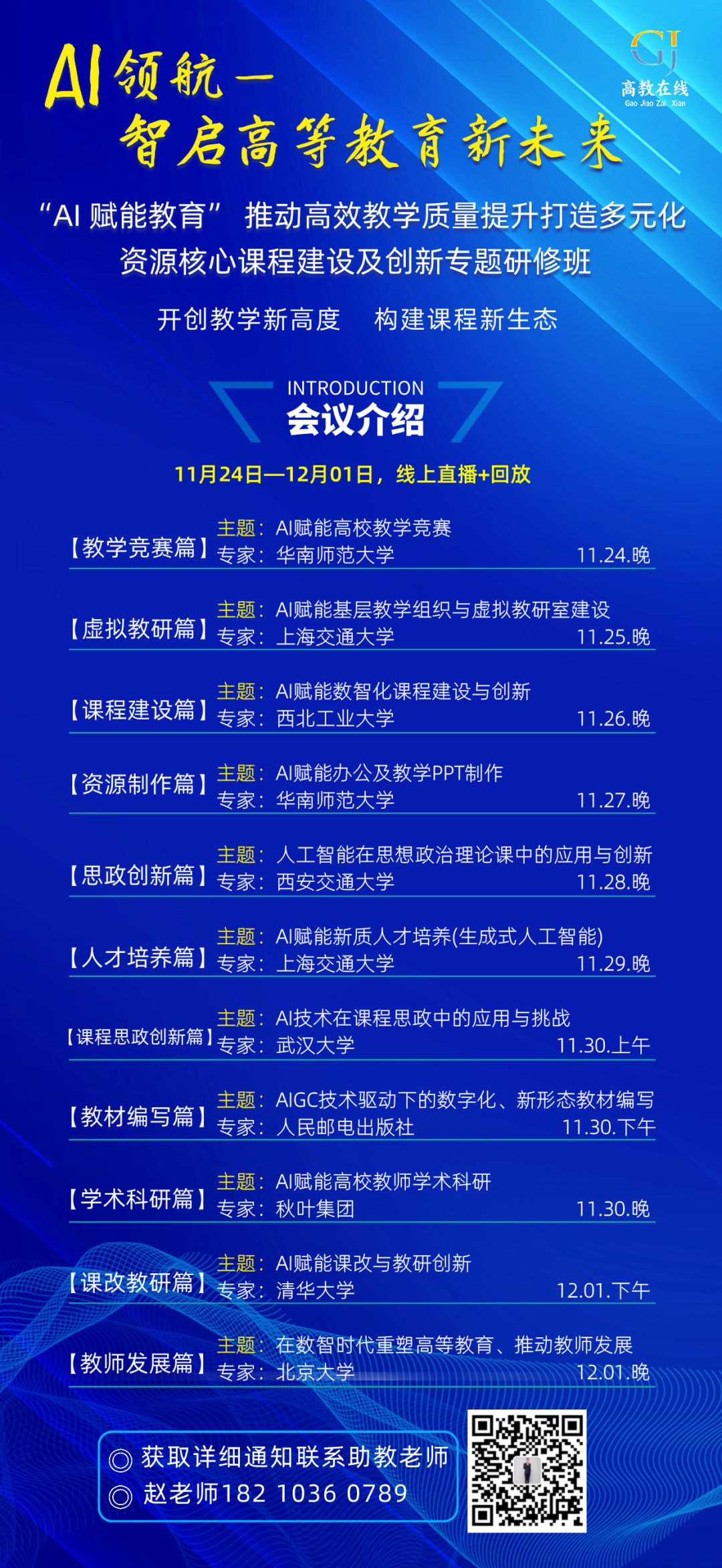

▍Stable Diffusion VS Midjourney

众所周知,AI绘画领域的顶端有两大工具:Stable Diffusion和Midjourney,不少人会纠结于两者,不知道该选择哪一个才好。

Midjourney使用非常简单,基本无门槛,线上使用,对硬件要求低,但需要付费和科学上网。用户只需专注自己的Prompt[//]: # (提示词,在AI绘画中Prompt是指一段文本或图像+文本,用于描述你想要生成的图像的样子。),就能出现精美的图片,而且复现其他人分享的Prompt也很容易。

Stable Diffusion开源,可以本地部署,无需联网,无需付费,尤其是可以训练专属于自己的模型,但硬件要求高,部署也较麻烦,学习成本高。用户不但要学习很多背景知识,而且要一定的动手能力。另外,即使你有对方的Prompt,也不容易复现。

以下是Midjourney和Stable Diffusion部分维度的对比。

![图片[2]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_1.png)

就我而言,我更加推荐Stable Diffusion。

安装和部署Stable Diffusion

介绍如何安装和部署Stable Diffusion。我使用的是B站UP主@秋葉aaaki的整合包,我这里只介绍该整合包的安装和部署。

▍背景信息

1. 从软件层面上讲,安装部署Stable Diffusion的方式主要有两种:一是传统原生安装方法,二是整合包安装方法。

传统原生安装:即从零开始安装部署Stable Diffusion,需要我们先部署所需的Python,Git环境以及依赖,再安装Stable Diffusion。操作较繁琐和有一定的门槛,这适合有编程基础,有一定经验的人。整合包安装:即一步到位,整合包里就有所需的Python,Git环境以及依赖、以及预设置好的部分模型和插件。整合包的出现就是为了避免繁琐的步骤,这非常适合小白,无任何经验的人。我个人推荐B站UP主@秋葉aaaki的整合包。

2. 从硬件层面上讲,安装部署Stable Diffusion也有两种方式:一是部署在云电脑上,二是部署到个人电脑上。

云电脑:是一种基于云计算的虚拟桌面服务,它可以让用户在任何地方使用任何设备访问其桌面和应用程序。如Microsoft Azure、Amazon WorkSpaces、腾讯云、阿里云等。需要掌握云端部署知识和进行付费。

个人电脑:即个人使用的电脑,对其有一定的性能要求,如你想玩3A游戏,那么就需要有高性能的电脑,使用Stable Diffusion同理。以下是结合诸多文章总结出来的推荐配置,大同小异。

电脑系统:Windows10及以上/macOS Monterey (12.5)。

显卡:RTX3060及以上。

显存:8G及以上。

内存:16G及以上。

磁盘空间:500 SSD及以上

3. Stable Diffusion主要消耗电脑显卡(GPU)和显存,显卡性能越强出图的效率越高,显存越大图片分辨率就可以设置的越高。

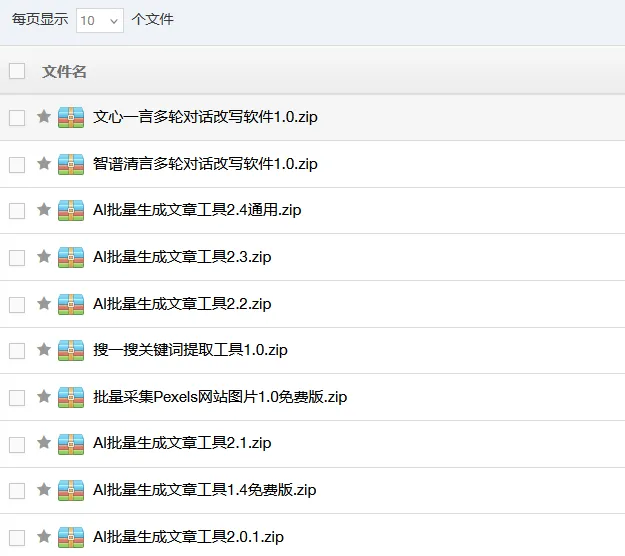

显卡如何选择?根据国外一个测评文章:不同显卡在生成512x512分辨率的图像时的速度,单位是每秒生成的图像数(it/s),显存默认8G。显示了Nvidia的RTX 40系列显卡是最快的(绿色和灰色),其次是AMD的RX 7900系列(红色),再次是Nvidia的RTX 30系列(深绿色和黑色),最后是AMD的RX 6000系列和Intel的Arc系列(蓝色)。所以,我更加推荐Nvidia的显卡(N卡),最低也得是RTX 3050 8G。我个人是使用的是RTX 3060 12G。

![图片[3]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_2.png)

若你不了解什么是显卡、内存等概念,可以观看此视频:

![图片[4]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_3.png)

▍前提条件▍操作步骤

步骤一:右键解压Stable Diffusion安装包。

![图片[5]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_4.png)

步骤二:双击Stable Diffusion安装包进入文件夹中,解压sd-webui-aki-v4.2。

![图片[6]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_5.png)

步骤三:双击启动器运行依赖-dotnet-6.0.11,安装所需依赖。

![图片[7]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_6.png)

步骤四:双击sd-webui-aki-v4.2进入该文件夹中,下拉找到A启动器并启动。

注:第一次启动,需要一些时间部署Python和Git环境,请耐心等待,后面启动就很快了。若未弹出WebUI界面,请将复制链接::7860 到浏览器中即可。

![图片[8]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_7.png)

若弹出Stable Diffusion WebUI界面,则表示启动成功。

![图片[9]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_8.png)

——结束

3Stable Diffusion WebUI界面介绍▍背景信息

Stable Diffusion WebUI是什么?它和Stable Diffusion有什么关系?

WebUI,全称Website User Interface,网页用户界面,是指采用图形方式显示的程序/软件的操作界面。如知乎网页版就是一个网页用户界面。

Stable Diffusion WebUI就是控制Stable Diffusion程序的一个网页界面。与早期Stable Diffusion使用的命令窗口相比,除了降低用户的操作负担之外,对于新用户而言,图形界面在视觉上更易于接受,学习成本大幅下降,也让Stable Diffusion的大众化得以实现。

正因为Stable Diffusion开源的特性,@AUTOMATIC1111 大佬才能为其设计了WebUI,并公布在GitHub上,至今有100K星,近20K的分享。

▍Stable Diffusion WebUI介绍

1. Stable Diffusion WebUI界面主要分为三个区域:模型选择区、功能选择区、参数配置区。

![图片[10]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_9.png)

2. 里面的参数非常多,第一次看到定会眼花缭乱,我对此进行了一次归类分组,这些参数主要分为两类:

一是为了告诉AI,用户的需求是什么,进而完成作图任务,称为基础参数。如提示词框、模型选择,迭代步数,采样器,图片尺寸等。

二是为了高效率地完成这个任务而存在的参数,称为额外参数,是非必要的参数。如垃圾桶,一键清除提示词、文件夹、打包下载、预设样式等。

那么,现在我们在看到某个参数时就知道它大致的作用是什么了。

![图片[11]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_10.png)

Stable Diffusion 布局/参数介绍

接下来我将依次介绍Stable Diffusion文生图功能中的参数,指导用户快速了解和使用这些参数,以便更好地出图。

注:1. 这里的参数介绍只起到指导性作用,若想进一步了解各个参数的细节和原理,请阅读后续的文章。2. 由于这是整合包相比较原生的Stable Diffusion安装包,功能较多,且已经汉化了。

模型选择区

![图片[12]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_11.png)

1. Stable Diffusion模型:下拉选择大模型,默认anyting-V5模型。请根据自身需求选择不同类型的模型,如现实主义风格的模型;动漫,二次元风格的模型。

2. 外挂VAE模型:下拉选择VAE模型,默认无。是可选操作,可以选择不同效果的VAE模型,对成图细节或颜色进行修复,同时选择VAE也可以起到节省电脑算力的作用。

3. CLIP终止层数(Clip Skip):滑动确认或输入层数,层数范围为1~12层,默认层数为2。1层,成图更加精确;2层,成图更加平衡,即AI遵循提示词,也有一定自己的创意;3-12层,成图更加有创意。这里推荐2层。若你希望AI更加有自己的创意,还是请调节提示词引导系数(CFG Scale)参数,效果会更好。

注:选择模型时,需要提前下载模型并存储到对应的路径中。模型下载可前往:huggingface网站或Civital网站。Stable Diffusion模型存储位置是:*modelsStable-diffusion。VAE模型存储位置是:*modelsVAE。存储完后,点击“”即可。

功能配置区

![图片[13]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_12.png)

1. 文生图(txt2img):根据文本描述生成对应的图片。

2. 图生图(img2img):根据图片、文本生成新的图片。如线稿上色,图片重绘。

3. 后期处理:对单张或多张图片进行放大,缩小处理。

4. PNG图片信息(PNG Info):上传图片即可解析图片的提示词和参数配置信息。

5. 模型融合:将2或3个模型进行融合。最终模型权重是前两个模型按比例相加的结果。需要 A、B 两个模型。计算公式为 A * (1 - M) + B * M。

6. 训练(Train):训练模型,可训练自定义的模型。

7. 系统信息:展示Stable Diffusion的服务器、版本、运行平台/状态、电脑内存等信息。

8. 附加网络(Addtional Networks):同时使用多个Lora模型的插件/拓展。

9. 无边图像浏览:即图片浏览器,拓展功能。可以更好地浏览和管理生成的图片。

10. 模型转换:将模型进行转换,如更换名字,权重等。

11. 超级模型融合:是模型融合功能的升级版,支持更多参数配置。

12. 模型工具箱:即分析某个模型的具体信息,以报告书的形式展示。

13. WD1.4标签器:即上传图片,分析图片的提示词以及评估提示词的权重。

14. 设置(Settings):设置Stable Diffusion工具,如图片存储路径,各个参数设置以及系统设置。

15. 拓展(Extensions):管理拓展功能,包括更新,删除拓展。

注:蓝色表示的功能是拓展功能,是秋叶整合包,自带的拓展,可以在设置中进行删除。

参数配置区

简单介绍各个参数信息,分为基础参数、额外参数以及老版本的参数。

![图片[14]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_13.png)

基础参数

1. 正向提示词(Prompt):输入你希望图片中出现什么内容。仅支持英文输入。

2. 反向提示词(Negative prompt):输入你不希望图片中出现什么内容,比如多手指。仅支持英文输入。

3. 迭代步数(Sampling Steps):设置图片去噪的步数,步数越多画面越精细,出图时间也越长。步数范围1~150步,1~19步更加模糊,粗糙;20~40步,更加平衡;40~150步更加精细。其中并不是步数越多越好,为了避免过犹不及,这里推荐20~40步,更加平衡。

4. 采样方法(Sampler Method):点击勾选采样方法。不同的采样方法,有不同效果,这里大家多次尝试即可。

5. 高分辨率修复(Hires. fix):勾选即可将图片的分辨率放大。如从512512px到10241024。

请根据自身显卡性能,设置图片基础分辨率,请勿设置的过高,否则在勾选高分辨率修复后,会显示:Out Of Memory Error,爆显存了。

6. Refiner:待补充。

7. 尺寸(宽度、高度):设置成图的尺寸。默认512512px。推荐的尺寸有:512768px、768512px、7681152。

8. 总批次数:指一次生成图片多少张,这里指陆续跑图。根据显卡性能,酌情设置,推荐1~4。

9. 单批数量:指一次同时生成几张图片,这里指同时跑图。显卡压力更大,不建议设置为2以上。

10. 提示词引导系数(CFG Scale):AI遵循提示词的程度/成图与提示词相关度。数值越低更加精确,越高则更有创造力,这里推荐5~7更加平衡。

注:该参数类似于New Bing对话框中的选择对话样式,分为更有创造力、更平衡、更精确。提示词引导系数(CFG Scale)则是以具体的数值来供用户设置。

![图片[15]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_14.png)

11. 随机种子数(Seed):设置成图是否随机。文本框默认-1,表示随机产生不同的图片。点击“”将随机种子设置为-1;点击“♻️”将成图的种子数(即唯一编码),设置为随机种子数,在其他参数不变的情况下生成的图片相似99%;点击“⏹️”则是进行更多设置。

12. Tiled Diffusion:待补充。

13. Tiled VAE:待补充。

14. Additional Networks:待补充。

15. ControlNet:又称控制网,是拓展功能。它为用户在图像生成过程中提供了额外的控制。例如,你将某图像的姿态动作使用ControlNet进行处理和分析,可将其姿态作为一个输入,接着你在输入提示词后,启动ControlNet功能,那么新的成图就会有该姿态。

注:ControlNet的极大地丰富了控制Stable Diffusion的方法,促进了用户个性化和自定义设计。它可以通过ControlNets参数来处理条件输入,如边缘映射、分割映射和关键点,从而丰富了控制大型扩散模型的方法。

16. 脚本(Script):一键测试提示词或各个参数变化对成图的影响。选项默认无,分为提示词矩阵、从文本框或文件载入提示词、X/Y/Z图表、controlnet m2m。

额外参数

1. 生成(Generate):在设置好所需参数后,点击生成让AI开始生成图片。

2. ↙:点击即可从上次提示词或上次成图中读取所有参数。

此外用户可在C站一键复制某张图的生成数据,并粘贴到SD的提示词框中,再点击“↙”,即可一键完成参数设置,不过模型选择需要手动设置。

3. :点击即可清空提示词内容。

4. :点击即可显示/隐藏拓展模型。分为大模型和小模型,点击即可应用。点击模型左上角的图标,即可将当前成图替换成该模型的预览封面。

5. :点击即可将所预设的样式插入当前提示词之后。

点击“”前,需先下拉选择预设样式。若没有预设样式,则需填写好提示词后,点击“”将当前提示词存储为预设样式。

6. :点击即可将当前提示词存储为预设样式。

7. 成图展示区:展示最终图片的区域。点击图片可放大查看,点击“❎”即关闭放大查看图片。

8. :点击即可查看所有成图的存储位置。

9. 保存(Save):点击,出现图片下载控件。

10. 打包下载(Zip):点击,将图片压缩,出现压缩包下载控件。

11. 发送到 图生图(Send to img2img):点击,将图片发送到图生图功能中。

12. 发送到 重绘(Send to inpaint):点击,将图片发送到图生图-局部重绘中。

13. 发送到 后期处理(Send to extras):点击,将图片发送到后期处理中。

14. 图片生成数据(Generation Data):该区域展示图片的生成数据,包括提示词、参数配置、耗时等。可选中进行复制粘贴。

老版本参数(SD1.5.1)

1. 面部修复(Restore faces):勾选即可修复成图脸部,这里较适合真人,不适合二次元和动漫人物。

2. 平铺图(Tiling):勾选将成图变成平铺图。平铺图:指将一张图片多次重复排列,填满整个画布的效果。以下是平铺图的一种:

![图片[16]-Stable Diffusion 用户指南-快速入门-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1721332888406_15.png)