![图片[1]-【LLM】大语言模型的知识融合-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1720033595139_0.png)

一、结论写在前面

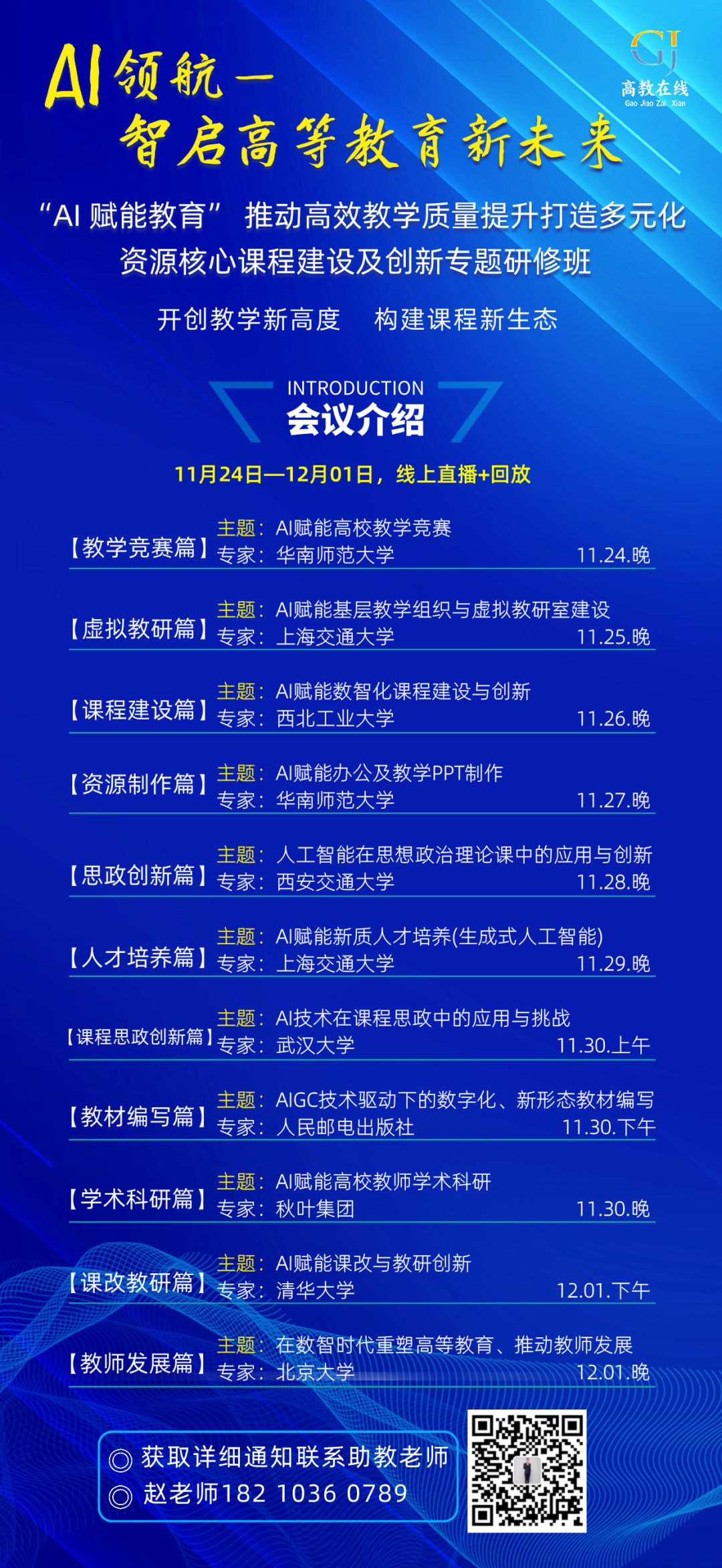

论文探索了LLM知识融合的领域,以创建一个统一的模型,结合多个结构多样的LLM的能力和独特优势。论文提出了一种新方法FUSELLM,它利用这些源LLM的生成分布来外化它们的知识,并在目标LLM的持续训练中使用它们。通过一系列实验,论文证明了FUSELLM优于单个源LLM和建立的基准。值得注意的是,在一个包含多个结构相同LLM的模拟实验中,与集成和权重合并方法相比,FUSELLM展示了其竞争力。因此,LLM融合领域作为一个更有前景的探索方向出现,特别是考虑到LLM的多种结构和大规模模型大小。

![图片[2]-【LLM】大语言模型的知识融合-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1720033595139_1.png)

二、论文的简单介绍2.1 论文的背景

随着GPT和LLaMA系列大型语言模型(LLM)在广泛的自然语言处理(NLP)任务中的持续成功,为企业创建自己的LLM已经成为一种战略需求。然而,LLM开发的成本是天文数字。除了需要大量的训练数据、先进的技术、大量的计算资源和熟练的劳动力外,开发过程还会对能源消耗和环境造成巨大压力。虽然这些LLM在结构和功能上存在差异,但它们在一系列NLP任务上共享类似的能力。因此,除了从头训练一个LLM的传统方法外,另一种选择是将现有的LLM组合成一个新的、更强大的LLM,在本文中称为LLM的知识融合(knowledge fusion of LLMs)。如果成功,这种融合不仅可以减少初始训练的成本,还可以让集成模型受益于所有LLM的优势。这个新模型也可以进行微调和适配各种下游任务。此外,融合也可以在专门用于某一特定任务的微调LLM之间发生。

![图片[3]-【LLM】大语言模型的知识融合-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1720033595139_2.png)

将多个模型的能力结合在一起的努力是一个长期的追求。例如,集成方法直接聚合不同模型的输出以提高预测性能和鲁棒性。然而,这种方法需要维护多个训练好的模型,并在推理时执行每个模型,由于LLM的巨大内存和推理时间需求,这在LLM中是不实际的。同样,这种方法不便于微调,而微调对许多LLM至关重要。另一种方法是通过逐参数算术运算直接将几个神经网络合并为一个网络。这种方法通常假设统一的网络体系结构,并试图在不同神经网络的权重之间建立映射,而这在LLM背景下通常是不可达成的。此外,当参数空间存在重大差异时,权值合并可能导致次优结果。

2.2 论文的方案

论文从概率分布的角度探索LLM的融合。对于一个输入文本,论文认为不同的源LLM生成的概率分布可以反映它们对理解该文本的固有知识。因此,提出的FUSELLM利用源LLM的生成分布来外化它们的集体知识和个体优势,并通过轻量级持续训练将它们转移到目标LLM。为实现这一点,论文开发了一种新的策略来对齐来自不同LLM的词元化,并探索了两种融合这些不同LLM生成的概率分布的方法。在持续训练过程中,FUSELLM非常强调最小化目标LLM的概率分布与源LLM的概率分布之间的差异。

为了实证FUSELLM的有效性,论文考察了LLM融合的一个具有挑战性且通用的场景,其中源模型共享性很小。具体而言,论文关注三个流行的开源LLM,它们具有不同的体系结构和功能:Llama-2、OpenLLaMA和MPT。跨越推理、常识和代码生成等总共42个任务的三个基准的评估证实,我们的方法训练的目标模型在大多数任务中优于每个源LLM和基准模型。此外,论文通过在几个特定领域的语料库上持续训练单个基础模型来模拟功能完全不同但体系结构相同的LLM的存在。在困惑度的评估中,与传统的集成和权重合并方法相比,论文的方法展示了在组合这些结构相同LLM的能力方面的卓越潜力。

2.3 论文的效果

论文探索了一个称为LLM融合的新挑战,其目标是创建一个统一的模型,能够有效地利用不同LLM的集体能力和独特优势。如图1所示,论文提出的方法通过知识外化和传递来优先融合多个LLM,与传统的集成和权重合并技术有明显区别。这项研究得出了几个可能引发未来研究的发现。首先,虽然论文通过在紧凑的高质量语料库上进行轻量级持续训练演示了我们的方法的有效性,但训练语料库的仔细选择对下游任务的相关性尤为关键。其次,在源LLM功能差异很大的情况下,融合函数在有效结合各自的优势方面似乎至关重要。最后,与传统的模型集成和融合技术相比,LLM融合领域似乎是更有前景的探索方向,特别是考虑到LLM的多种结构和庞大的模型大小。

![图片[4]-【LLM】大语言模型的知识融合-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1720033595139_3.png)

![图片[5]-【LLM】大语言模型的知识融合-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1720033595139_4.png)

![图片[6]-【LLM】大语言模型的知识融合-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/07/1720033595139_5.png)

论文标题:Knowledge Fusion of Large Language Models

论文链接: